AI-verktøy i den kreative fasen

Hvordan optimalisere den kreative prosessen?

I denne guiden undersøker låtskriver og produsent Joakim With Steen hva som skjer når kunstig intelligens (AI) brukes i idéfasen.

Han ønsker å forstå hvordan AI kan bidra til å realisere egne idéer, visjoner og tanker, snarere enn kun å vise frem hva AI kan gjøre.

Av Joakim With Steen

— Sist oppdatert:Intro

Idéfasen er den delen av produksjonsprosessen hvor AI oppfattes som ekstra «nytt», og det er til dette formålet det nå dukker opp mest nye AI-applikasjoner som ikke likner like mye på det man har sett før.

Jeg skal gå gjennom en del verktøy jeg har testet den siste tiden.

-

Det er tre typer tekst som omtales når jeg går igjennom disse verktøyene:

tekst i form av sang-tekst

tekst i form av en «prompt» som det ofte heter i AI-verdenen. Det å «google» er i ordboken, men det å «prompte» er litt klønete å finne svar på. Men en «ledetekst» ville kanskje være et passende ord. Det man skriver inn i disse «promptene» vil ha ekstremt mye å si for hva du vil få tilbake

tekst i form av tale. Dette er relevant for i noen tilfeller snakker AI-verktøyene tilbake, og analyserer det du sier når du snakker til den.

I de fleste, om ikke alle tilfeller, av AI-verktøyene jeg har prøvd, fungerer det på denne måten:

Menneskelig input (prompt) -> AI bearbeider (algoritmer, maskinlæring, osv) -> output (resultat: gjerne en lydfil)

-

1) Prompt til tekst

- AI som generer sangtekst basert på din beskrivelse

- AI som gir feedback for å forbedre eksisterende sangtekst

- AI som foreslår musikkteori-basert info

2) Prompt til lyd

- AI som genererer melodi og/eller harmoni og rytmikk

3) Tekst (sangtekst) til lyd

- AI som genererer vokal og komp til en sangtekst

4) Lyd til lyd

- stemmekonvertering

- automatisk mastering

- effekter og prosessering (for eksempel AI som legger til effekter som reverb, delay, osv.)

5) Lyd til tekst

- AI som analyseverktøy som gir tilbakemeldinger på miks og master

- AI som analyserer lyd for å generere et filter den kan bruke for å finne sortere lyder fra et arkiv

Joakim With Steen har blant annet vunnet MGP og deltatt i Eurovision med artistprosjektet JOWST i 2018 og som låtskriver for Polen (!) så sent som i 2022.

Foto: Tord Litleskare

Kort om Joakim

Jeg har jobbet aktivt med låtskriving de siste seks årene, og har laget flere hundre låter og skisser sammen med nesten like mange låtskrivere, artister og produsenter. Trives best med samarbeid i den kreative prosessen, ovenfor å jobbe alene.

Kreativt har min hovedrolle vært å være produsent, hvor jeg også bidrar til låtskrivingen. Selv synes jeg min styrke som låtskriver ligger i konseptutvikling. Jeg er mer fokusert på det konseptuelle og overordnede, og har en mer flytende tilnærming sammenlignet med for eksempel en tekstforfatter som primært fokuserer på tekst, eller en topliner som primært fokuserer på melodi.

Jeg har stor interesse for ny teknologi og tester stadig det nyeste innen programvare og plugins, særlig de som forbedrer arbeidsflyten og lar kreativiteten blomstre best mulig.

Moises

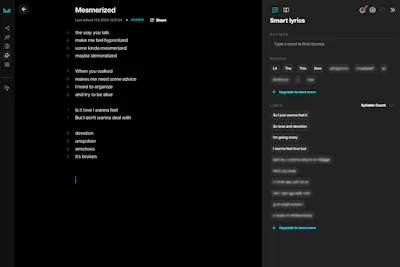

Dette er brukergrensesnittet på låtskriverapplikasjonen til Moises, via nettleser.

Foto: Skjermdump/Moises

Moises er en slags «låtskriverassistent», som foreslår rim, teller stavelser og plasserer rimet i enden av linjer med gitte antall stavelser.

Man kan også velge stemning på låta, og forslagene endres deretter.

Dette er etter min mening mye mer interessant og fint for workflow enn det å jobbe i notater, Word eller Google Docs, med for eksempel RhymeZone i et separat vindu i en nettleser.

Se et eksempel på en tekst jeg laget i Moises her.

-

Lar deg finne rim og telle stavelser på en måte som ikke forstyrrer arbeidsflyten (gratisversjonen er begrenset, men fungerer uten forstyrrelser).

-

Om man vil ha tilgang på denne tjenesten må man betale det dyreste alternativet.

Nedsiden ved det er at man betaler for mange andre funksjoner, ikke bare skrive-delen, som jeg synes var den største kreative fordelen i dette AI-verktøyet.

Riffusion

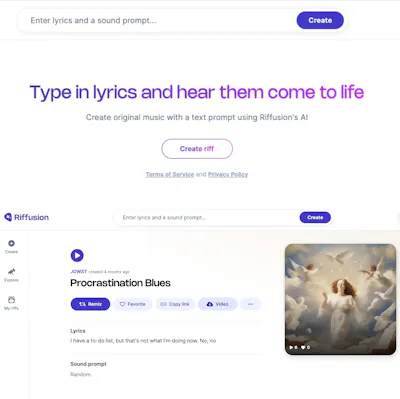

Skriv inn en linje, og få en melodi tilbake i nettleseren.

Foto: Skjermdump/Riffusion

-

Applikasjonen lager melodier som føles ganske random til den teksten du har. Noe som kan være fint om man for eksempel står fast, eller bare er helt tom for ideer.

-

Det meste faller ikke i smak for meg. Jeg prøver ganske mye før jeg finner noe inspirerende.

Suno

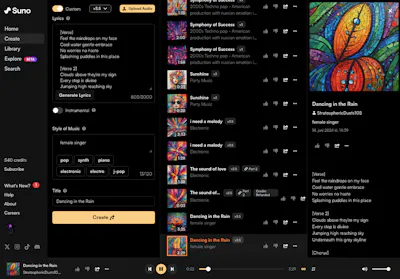

Her genereres musikk basert på tekst og andre tilvalg via applikasjon i nettleseren.

Foto: Skjermdump/Suno

Suno lager musikk basert på prompts og sangtekst, enten «låtbeskrivelse» eller en kombinasjon av dette og sangtekst.

Man kan også velge å lage en instrumental, eller ta utgangspunkt i en tittel.

Jeg lagde dette og dette eksempelet på et par minutter, og synes selv det var bra og inspirerende. Jeg bestemte meg for å trykke på «extend» på det første eksempelet, endret tittelen til «The Sound of Love» og fikk dette.

-

Den lager musikk som du mest sannsynlig ikke ville laget selv. Veldig fort. Det er mye å hente av inspirasjon og ideer.

Man trenger ikke nødvendigvis bruke selve lyden som kommer ut, men heller ta melodiene videre.

-

Det er ikke så lett å jobbe videre med som man kanskje skulle ønsket, spesielt ikke fra en produsents perspektiv.

Man vil gjerne forandre på noen småting, erstatte noe eller lignende. Da hadde det vært en stor fordel å kunne få stems eller enkeltspor.

Tips

For å jobbe videre med disse eksemplene, i form av stems, er det nødvendig å laste ned resultatet, og så laste det opp igjen i en stem-splitter. Dette er antagelig det som det kommer mest lignende tjenester på nå for tiden. Det er mange nettsteder, blant annet flere av de jeg allerede nevner her, som tilbyr denne tjenesten. Jeg endte opp med å bruke programmet RipX DAW, som jeg skriver om litt lenger nede.

Udio

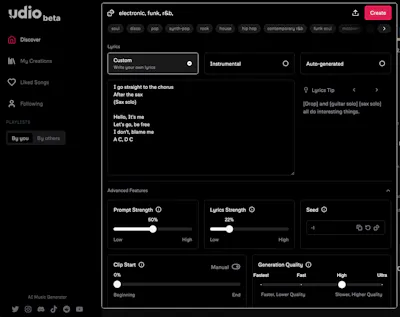

Her testes Udio, med egenskrevet tekst i nettleser-applikasjonen.

Foto: Skjermdump/Udio

Udio genererer all type musikk (instrumentalt eller med vokal) basert på tekst og diverse tilvalg. Du kan også laste opp musikk/lyd som den skal basere seg på. Denne tjenesten er veldig lik Suno, men gir andre resultater.

Jeg lagde dette og dette eksempelet. Etter å ha forandret innstillingene via «remix»-knappen på det andre eksempelet, fikk jeg dette og dette resultatet. Da jeg trykket på «extend» på den siste, fikk jeg dette resultatet (hør spesielt på slutten som jeg valgte at skulle genereres automatisk av AI).

-

Udio lager også ting (ideer) som du ikke ville laget selv.

-

På samme måte som med Suno, hadde jeg foretrukket å få stems å jobbe videre med.

Tips

Kreativt er Udio veldig lik Suno, selv om Udio kanskje er bedre på enkelte sjangere og ting som gjerne skal høres mer organisk ut. Om du liker en av disse er det verdt å teste begge, for å se hvilken du skal investere mer tid og eventuelt penger i.

RipX DAW

Eksempelbilde av flerstemte vokalspor, i programvaren installert på maskinen.

Foto: Skjermdump/RipX DAW

Det jeg bruker RipX DAW til forklares godt i denne posten.

Helt generelt bruker jeg denne applikasjonen for å analysere, splitte, bearbeide og eksportere stems fra lydfiler jeg genererer med AI. Den lar deg altså hente ut enkeltlyder/spor fra en produksjon (én lydfil med alle lyder), som er en fin funksjon som kompletterer andre AI-verktøy som ikke gir deg separate spor.

-

Bruk ting du ikke har lov til å bruke som placeholders.

Av og til kan det være nyttig å for eksempel bruke en trommegroove fra en allerede utgitt sang, som en placeholder.

Som eksempel kan du tenke at One Republics «I Ain’t Worried» har den perfekte trommegrooven for den låta du og noen andre skriver akkurat nå. Da kan du altså laste ned den låta og dra den inn i RipX DAW, for deretter å få kun trommene som en egen lydfil.

-

Det kan være vanskelig å gjenskape noe veldig unikt dersom du gjør det slik som jeg beskriver over.

Tips

En grunn til at enkelte AI-verktøy ikke gir deg separate spor (stems) kan være fordi den genererer noe som ligner på «snapshots» av musikk (frekvenser), som den er trent på. Det er altså ikke nødvendigvis en bassgitar sammen med et piano som spiller noe konkret. For eksempel er Riffusion ganske så «blurry» i sine instrumentalspor. Hvert enkelt sekund høres noenlunde ekte ut, men det er sjeldent en hel lyd (som i et anslag, sustain og decay, eventuelt med klang og ekko).

Emergent Drums 2

Plugin, åpnet inne i et DAW. Spilles live uten latency.

Foto: Skjermdump/Emergent Drums 2

Emergent Drums 2 er en generativ trommemaskin, som genererer tromme-lignende lyder, basert på synth-lignende parametre og støy. Det er lagt opp til å lage et trommemaskin oppsett, med seksten lyder, fordelt på 4X4 visuelle pads.

Lydene som genereres er i stor grad til å kjenne igjen, og man kan gå ut ifra en preset, og så ved hjelp av AI, generere og forandre lydene en og en.

-

Den lager helt unike lyder som ingen andre har, selv om det kan virke veldig likt.

Disse lydene oppfører seg gjerne litt annerledes enn normalt, som kan være en kreativ gnist, eller i det minste en påvirkning som får deg til å gjøre noe annet enn hva du ellers ville gjort.

-

Det er ikke så mye kreativt å hente. La oss se på dette som en slags tennstift som er nødvendig for å starte en kreativ prosess.

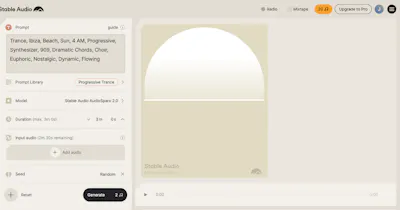

Stable Audio

Brukergrensesnittet til Stable Audio. Både enkelt og avansert.

Foto: Skjermdump/Stable Audio

Du kan jobbe med Stable Audio via tekst eller lyd.

I første tilfelle vil AI-modellen sende ut lyd basert på instruksjonene du gir den, for eksempel sjanger, undersjanger, stemning og instrumenttype.

Du kan også laste opp lydopptak eller ta direkteopptak i Stable Audio, og bruke disse videre.

-

Ting blir relativt bra, og jeg finner AI-mistolkingen, som ofte oppstår, å være ganske interessant

-

Du burde i stor grad vite hva det er du vil ha før du genererer det i lyd-til-lyd modellen.

Og ting tar gjerne litt lang tid.

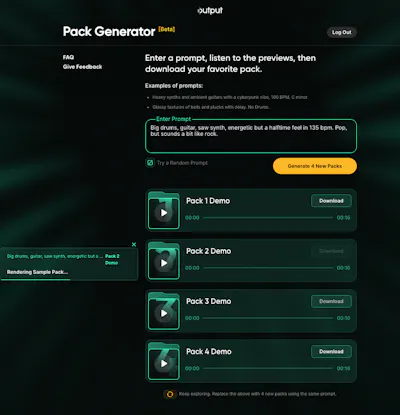

Co-Producer

Slik ser det ut når man har trykket «generate».

Foto: Skjermdump/Co-Producer

Co-Producer er en samplepakke-generator.

Her beskriver du hva du vil ha, også brukes AI til å analysere det du mener/beskriver, for å så finne samples og loops som matcher og prosesserer dem for å passe sammen. Til slutt får du høre fire resultater og kan gi tommel opp eller ned for å lære verktøyet hva du liker.

Dette påvirker også hva du får senere.

-

Den gir deg ikke bare det du hører, men alle andre loops og samples i sin originale kvalitet, slik at du kan bruke de og andre lignende filer til å lage andre/nye partier som høres passende ut.

Det går ganske fort, og er utrolig nok helt gratis.

-

Alle andre kan bruke de samme filene, så prøv å ikke fokusere for mye på de melodiske elementene blant filene.

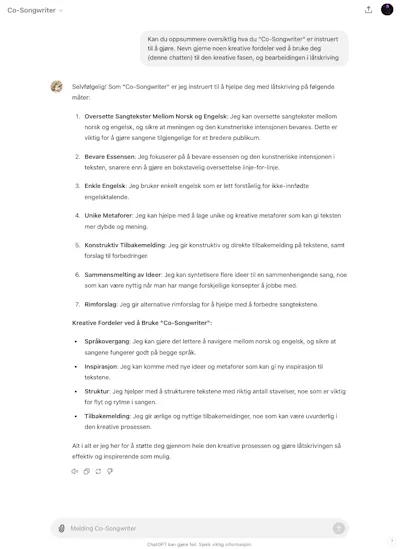

ChatGPT

En oppsummering gjort av ChatGPT selv, om hva denne GPT-en er trent for å gjøre.

Foto: Skjermdump/ChatGPT

ChatGPT er et allsidig verktøy som kan hjelpe deg i din kreative prosess når du skriver nye låter, og utvikler nye idéer.

For de som ikke har brukt slike AI-verktøy før, kan ChatGPT bidra til å organisere tanker, generere ideer og gi nyttige tilbakemeldinger på tankene dine, som kanskje vil gjenspeiles i tekstene dine.

Jeg har testet både gratisversjonen og et såkalt plus-abonnement. Fordelen med sistnevnte er at du får tilgang til å kunne lage (instruere, trene og modifisere) din egen GPT.

Selv laget jeg en GPT som jeg kaller for «Co-writer». Denne vet selvfølgelig alt som OpenAI allerede vet, men i tillegg til dette har jeg lagt inn instruksjoner som ligger inne før hvem som helst starter en ny chat med denne GPTen.

Du og alle med link kan bruke denne her (merk at du også må ha et plus-abonnement for å bruke denne og andre modifiserte chatter laget av andre).

-

Man kan snakke med den, som Siri eller Alexa. Man kan også stoppe snakkingen og lese det man har sagt og det ChatGPT har sagt.

Sammenlignet med et Google Docs-dokument, som har blitt en slags bransjestandard i låtskriververdenen, har ChatGPT evnen til å organisere og gjøre det visuelt mer oversiktlig for deg. Det kreves en litt annen tankemåte som forstyrrer «flowen» når man skal fikse overskrifter, skrivefeil osv.

Med plus-abonnement får du også forbedret responskvalitet, bedre tilbakemeldinger og raskere svartid.

-

Det er lett å bli ledet i en retning man ikke hadde tenkt seg. Jeg merker at ChatGPT ofte bruker generiske metaforer, sannsynligvis for å unngå å kopiere opphavsrettsbeskyttet materiale.

Når vi mennesker skriver tekster, forholder vi oss til de få tekstene vi husker. ChatGPT derimot, har tilgang til tusenvis av sangtekster, og må derfor være ekstra nøye med å unngå å gjenta opphavsrettsbeskyttet innhold.

PS: Vær også bevisst på AI-hallusinasjoner.

Tekstlikheter

I et at mine prosjekter, hvor jeg lagde en låt med stor hjelp fra ChatGPT, ville jeg bruke linjen «ice ice baby» som en liten adlib, for å referere til «vanilje». Dette flagget ChatGPT og påpekte at det var identisk med en linje i Vanilla Ice sin låt og at jeg burde vurdere å bruke noe annet. ChatGPT er altså klar over låttekster som finnes fra før, og forholder seg til dem. Kanskje derfor er det automatisk litt sånne klisjé-aktige linjer som kommer ved første forsøk om du ønsker å få ChatGPT til å lage en låt kun basert på for eksempel en tittel.

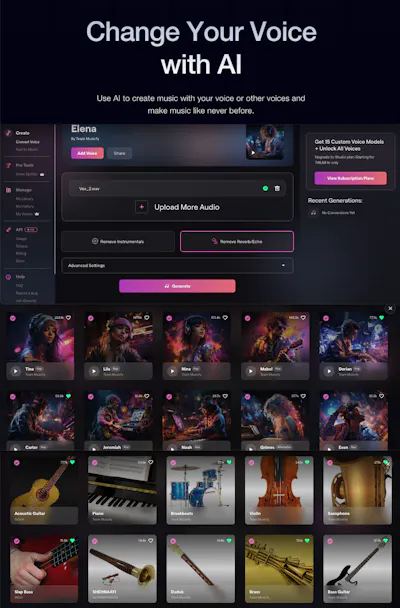

Musicfy

En oversikt over noen utvalgte stemmer og instrumenter du kan konvertere ditt opptak til.

Foto: Skjermdump/Musicfy

Musicfy er AI-verktøy som har forskjellige funksjoner: «Stem splitter», «text-to-music» og den funksjonen jeg tar for meg i denne guiden: «Convert voice» - endre en stemme til en annen.

Her kan du ta opp din egen stemme direkte inn i programvaren du åpner i nettleseren, og så konvertere den til noen som høres ut som et annet kjønn, en annen alder med en annen stil. Eller til et instrument.

Om du vil ha det gøy, kan du sjekke hvordan låta di ville hørtes ut om Eminem var den som sang.

Info

Det er ikke dette (ref. Eminem) jeg bruker Musicfy til. Dette er gjerne kult å teste, men du kan ikke lovlig bruke resultatet i en utgivelse. Grunnen til at Musicfy er et lovlig verktøy til stemmekonvertering, er at de har mange trente AI-modeller som man betaler en lisens for å bruke. Skaperen av disse AI modellene har gjerne også brukt to forskjellige stemmer for å trene én stemme, som også kanskje gjør denne mer etisk riktig å bruke. Jeg har brukt denne for å endre min stemme til en annen.

Motivasjonen min for å bruke denne tjenesten, var et jeg tenkte jeg kunne få min dårlige sangstemme til å høres kulere/bedre ut.

Fungerer det? Både ja og nei

-

Analysér «gibberish»: Mange liker å finne/lage melodier og rytmikk ved hjelp av å synge på et uforståelig språk, som kanskje ligner litt på engelsk (om det er engelsk tekst man lager).

Jeg har funnet denne stemmekonverteringen kreativt behjelpelig ved å konvertere slike type opptak. Det er akkurat som om at den overanalyserer hvilke lyder jeg lager. Likevel vil dårlig uttale og dårlig pitch bli med i denne konverteringen. I mitt tilfelle er det fortsatt behov for autotune etter at stemmen har blitt konvertert, men kanskje ikke like mye som før.

Som musikkprodusent (eller bare artist med lite tro på egen stemme i den kreative fasen, hvor man ikke vet hvordan låta går, og ikke klarer å synge slik man ønsker) kan det være motiverende å høre denne konverterte stemmen. Det gjør at man kan fokusere på andre ting.

-

Det tar såpass lang tid å konvertere at det ødelegger den kreative flyten.

Avhengig at internetthastigheten, tar det gjerne to-tre minutter totalt. For man må først eksportere lyden fra DAW, finne opptaket i mappesystemet, laste det opp på nettsiden, velge hvilke(n) stemme man vil bruke, trykke på konverter, vente i ca +/- ett minutt (avhengig av størrelsen/lengden på filen) laste den ned, og så importere dette til ditt DAW.

For min del gjør denne prosessen at det blir veldig lett å skifte fokus fra det du egentlig gjorde, og slik du egentlig tenkte, til å bli mer avventende, kanskje filosofisk og overanalytisk osv.

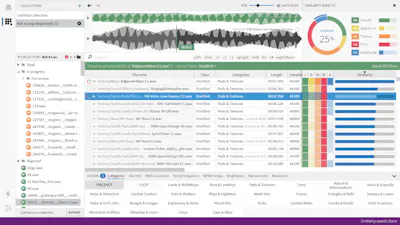

Sononym

Eksempelbilde av åpen programvare, installert lokalt på maskinen.

Foto: Skjermdump/Sononym

Den relevante funksjonen som jeg fant mest unik og interessant i Sononym, var at jeg kunne laste opp en lydfil, eller ta opp en lydfil direkte i programmet. Enten ved å velge min iPhone som opptakskilde, eller ved å eksportere noe relevant fra mitt prosjekt, som jeg da kunne slippe inn i programmet.

Den analyserer så lyden, for å så kunne sortere alle lydene du har lagret på din egen maskin, for å kunne forslå hvilke samples og loops som matcher best. Enten generelt, eller basert på amplitude, pitch, spectrum og timbre.

Det jeg fant mest interessant var å sortere resultatene etter timbre. Da det er lett å endre volum (amplitude) og til dels pitch.

-

Det er lett å finne nye passende lyder, kun basert på det soniske innholdet du allerede har.

-

Om man begynner med denne prosessen som jeg beskriver over for tidlig, kan man ende opp med å utvikle nye ideer på nye premisser. Man kan gå videre bare fordi det passer så godt sonisk. Noe som kan påvirke veien videre litt for mye.

Mitt tips er derfor å bruke Sononym for å komme videre på produksjonen i stedet for selve låta og melodiene.

Soundraw

Slik ser det ut når du har generert musikk, som du så kan rearrangere i nettleseren.

Foto: Skjermdump/Soundraw

I Soundraw kan man bruke enkle parametere som sjanger, «mood» og lignende.

Men da jeg fant noe jeg syntes var fint, som jeg kunne tatt videre, fant jeg ut at dette var musikk som allerede var generert for andre. Ved å bruke appen Shazam fant jeg en utgitt låt som brukte det samme.

Derfor var det uaktuelt å ta dette med videre.

-

Den lager noe som høres veldig bra ut veldig fort.

-

Den lager ikke (nødvendigvis) noe originalt som ingen andre har brukt eller skal bruke.

Siden det høres så bra ut ved første tastetrykk er sjansen stor for at noen har brukt det eller noe lignende.

Jeg valgte å ikke teste dette videre fordi jeg ikke følte det hjalp meg å være kreativ. Kanskje litt, men den mengden kreativitet som kom var et resultat av noe som er like uoriginalt som en loop eller en songstarter via Splice.

Soundraw ser jeg derfor mer som et godt alternativ for eksempel for en rapper som normalt ville kjøpt en beat via YouTube eller BeatStars.

Til slutt

Det jeg ønsker å være bevisst på når jeg bruker disse verktøyene, er om de har påvirket resultatet i så stor grad at jeg som opphavsperson ikke føler at jeg kan stå inne for å kreve 100% av opphavsrettighetene på verket.

Det kan skje om det som blir laget er eller blir potensielt uoriginalt (ikke unikt). For det kunne like gjerne ha blitt laget for noen andre, eller det kan lages for noen andre i ettertid.

-

En ting man som artist, og som produsent for andre artister, gjør, er å formidle en identitet. Den identiteten er gjerne, og kanskje aller helst, er refleksjon av din egen identitet.

For meg er det er min smak og min evne til å stå inne for det jeg liker og ikke liker som utgjør min identitet. Men, alt det jeg jeg lager og som jeg putter min identitet igjennom, blir gjerne ikke fullført, eller får ikke se dagens lys.

Jeg tror at AI kan hjelpe til med å komme frem til flere ferdigstilte prosjekter, og være en assistent for deg når du prøver å formidle din identitet. Men det er viktig å huske på at disse resultatene man får underveis ikke nødvendigvis er resultater, selv om de AI-genererte musikkverkene nesten høres ut som et ferdigstilt prosjekt.

Som eksempel kan et AI-generert bilde være én av de 17 bildene du trenger for å skape ditt moodboard, når du skal utvikle artwork til din neste singel.

-

Jeg har testet veldig mange plugins. Majoriteten av pluginsene er lik andre plugins. Veldig mange er digitaliserte videreføringer av gamle analoge verktøy. Noen gang er de kamuflert i et nytt navn eller et nytt design. Det er veldig vanlig å ha visuelle riper i lakken og slitte skruer. Og sjelden er de pluginsene som skal herme etter en analog UA 1176-kompressor veldig skuffende. De høres egentlig ganske identiske ut alle sammen. I det minste om man spiller av resultatet med samme volum.

Når det kommer til AI-verktøy, varierer det likevel veldig. Ikke bare på design, brukervennlighet og funksjonalitet, men det varierer også i hvilken grad det er AI der.

AI har vist seg å være en spennende, frustrerende og nyskapende kreativ partner. Verktøy som bruker AI, kan gi helt nye måter å jobbe på. Samtidig er noen av verktøyene som påstår å ta i bruk AI egentlig bare eksisterende verktøy i ny innpakning.

Jeg ser for meg at jeg kommer til bruke AI i musikkproduksjonen min fremover. Jeg vil likevel oppfordre andre som tar dette i bruk å være kritiske og bevisste på at det de generer også kan bli generert for andre.

-

Det finnes mange AI-verktøy som ikke er nevnt i denne guiden, og det kommer stadig vekk nye.

Prinsippet om at man gir AI-verktøyet noe, som den så behandler eller genererer noe ut ifra, og gir noe tilbake, kommer likevel til å være likt. Noen ganger gir man AI-verktøyet tekst i form av sangtekst, noen ganger gir man lyd/musikk som verktøyet så lager noe nytt basert på, eller behandler, og noen ganger prompter man ved å oppgi ideer, beskriver stemning, sjanger, instrumentering, tempo, energi osv. Noen av disse verktøyene har også mer å tilby.

Målet med denne guiden er å gi deg et bedre overblikk over hva som kan gjøres med AI-verktøy i den kreative fasen.

-

Den største utfordringen med AI i den kreative fasen er nok det at det er en såpass stor forsinkelse fra input til output.

Når man synger inn i en mikrofon, som sendes til et DAW, som prosesseres med en autotune, kompressor, distortion, klang, delay og EQ har gjerne totalt fem millisekunder forsinkelse. Dette oppfattes som ingen forsinkelse. Det er gjerne ved tolv millisekunder at forsinkelsen påvirker fremføringen.

Noen plugins som for eksempel Little Alterboy (stemmeforvrenging i form av pitch og formant) har over femti millisekunder forsinkelse, og blir derfor vanskeligere å jobbe med i den kreative fasen.

Når det tar to minutter å få en stemme til å høres ut som en saksofon, blir det mindre spontant og kreativt å jobbe med. Men dette er også noe som blir bedre og bedre. Det kan godt hende at det blir mulig å laste ned programvarer med hele algoritmen som maskinen bruker for å konvertere lokalt, for å så få omtrent null forsinkelse.

Det finnes programvare som kan gjøre slike ting nå, men det er også gjerne slik at de AI-verktøyene med mest forsinkelse høres bedre ut enn de verktøyene med lite forsinkelse.

Gi oss tilbakemelding!

Dersom du oppdager feil, har kommentarer eller innspill, hører vi mer enn gjerne fra deg!

hei@musikkontoret.no

Forbehold

Vi jobber hardt for å levere innhold som til en hver tid er oppdatert og riktig. Det kan likevel hende at artikler på Musikkontoret.no inneholder feil og mangler.

I slike tilfeller står ikke Musikkontoret ansvarlig for eventuelle utfordringer eller problemer dette måtte forårsake.

Relatert innhold

Mastering: Loudness i streaming og sende miks til mastering

Hvor høy skal musikken min være? Og hva må jeg huske på før jeg sender den til mastering?

— Dette sparer oss tid og gir oss nye kreative muligheter